1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

293

294

295

296

297

298

299

300

301

302

303

304

305

306

307

308

309

310

311

312

313

314

315

316

317

318

319

320

321

322

323

324

325

326

327

328

329

330

331

332

333

334

335

336

337

338

339

340

341

342

343

344

345

346

347

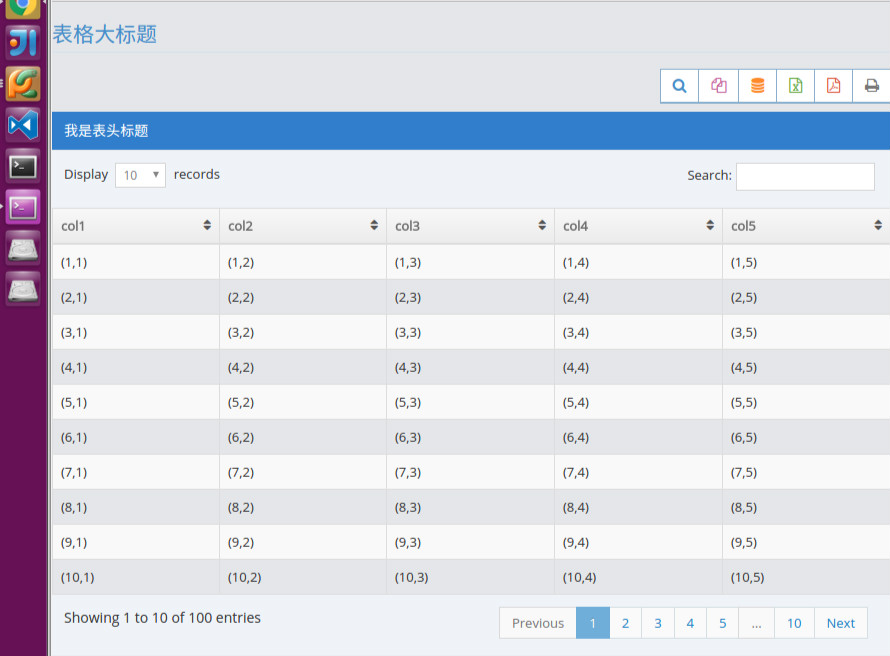

| {% extends 'base.html' %}

{% block title %}

DataTables演示

{% endblock %}

{% block body %}

<div>

<div class="row">

<div class="col-xs-12">

<!-- PAGE CONTENT BEGINS -->

<div class="row">

<div class="col-xs-12">

<h3 class="header smaller lighter blue">

表格大标题

</h3>

<div class="clearfix">

<div class="pull-right tableTools-container"></div>

</div>

<div class="table-header">

我是表头

</div>

<!-- div.dataTables_borderWrap -->

<div>

<table id="dynamic-table"

class="table table-striped table-bordered table-hover">

<thead>

<tr>

</tr>

</thead>

<tbody>

</tbody>

</table>

</div>

</div>

</div>

<div id="modal-table" class="modal fade" tabindex="-1">

<div class="modal-dialog">

<div class="modal-content">

<div class="modal-header no-padding">

<div class="table-header">

<button type="button" class="close" data-dismiss="modal"

aria-hidden="true">

<span class="white">×</span>

</button>

Results for "Latest Registered Domains

</div>

</div>

<div class="modal-body no-padding">

<table class="table table-striped table-bordered table-hover no-margin-bottom no-border-top">

<thead>

</thead>

<tbody>

</tbody>

</table>

</div>

<div class="modal-footer no-margin-top">

<button class="btn btn-sm btn-danger pull-left" data-dismiss="modal">

<i class="ace-icon fa fa-times"></i>

Close

</button>

<ul class="pagination pull-right no-margin">

<li class="prev disabled">

<a href="#">

<i class="ace-icon fa fa-angle-double-left"></i>

</a>

</li>

<li class="next">

<a href="#">

<i class="ace-icon fa fa-angle-double-right"></i>

</a>

</li>

</ul>

</div>

</div>

<!-- /.modal-content -->

</div>

<!-- /.modal-dialog -->

</div>

</div>

<!-- /.page-content -->

</div>

</div> <!-- 单独一个完整报表展示-->

{% endblock %}

{% block js %}

{{ super() }}

<!-- DataTables Js-->

<script src="{{ url_for('static', filename='assets/js/jquery.dataTables.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/jquery.dataTables.bootstrap.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/dataTables.buttons.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/buttons.flash.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/buttons.html5.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/buttons.print.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/buttons.colVis.min.js') }}"></script>

<script src="{{ url_for('static', filename='assets/js/dataTables.select.min.js') }}"></script>

<script type="text/javascript">

var table = $('#dynamic-table')

var aoColumns = []

$.ajax({

contentType: "application/json; charset=utf-8",

url: "{{ url_for('data_table.cols') }}",

type: 'post',

success: function (resp) {

$.each(resp.columns, function (i, v) {

table.find('thead > tr').append('<th>' + v + '</th>')

aoColumns.push({"title": v})

});

showTables(table, aoColumns)

}

});

function showTables(dom_table, cols) {

//initiate dataTables plugin

var myTable = dom_table.DataTable({

bAutoWidth: false,

"aoColumns": cols,

"aaSorting": [],

//"bProcessing": true,

"bServerSide": true,

"sAjaxSource": "{{ url_for('data_table.data') }}",

"fnServerData": function (sSource, aoData, fnCallback) {

$.ajax({

'dataType': 'json',

'type': 'POST',

'url': sSource,

'data': aoData,

'success': fnCallback

});

},

//,

//"sScrollY": "200px",

//"bPaginate": false,

//"sScrollX": "100%",

//"sScrollXInner": "120%",

//"bScrollCollapse": true,

//Note: if you are applying horizontal scrolling (sScrollX) on a ".table-bordered"

//you may want to wrap the table inside a "div.dataTables_borderWrap" element

//"iDisplayLength": 50

select: {

style: 'multi'

}

});

$.fn.dataTable.Buttons.defaults.dom.container.className = 'dt-buttons btn-overlap btn-group btn-overlap';

new $.fn.dataTable.Buttons(myTable, {

buttons: [

{

"extend": "colvis",

"text": "<i class='fa fa-search bigger-110 blue'></i> <span class='hidden'>Show/hide columns</span>",

"className": "btn btn-white btn-primary btn-bold",

columns: ':not(:first):not(:last)'

},

{

"extend": "copy",

"text": "<i class='fa fa-copy bigger-110 pink'></i> <span class='hidden'>Copy to clipboard</span>",

"className": "btn btn-white btn-primary btn-bold"

},

{

"extend": "csv",

"text": "<i class='fa fa-database bigger-110 orange'></i> <span class='hidden'>Export to CSV</span>",

"className": "btn btn-white btn-primary btn-bold"

},

{

"extend": "excel",

"text": "<i class='fa fa-file-excel-o bigger-110 green'></i> <span class='hidden'>Export to Excel</span>",

"className": "btn btn-white btn-primary btn-bold"

},

{

"extend": "pdf",

"text": "<i class='fa fa-file-pdf-o bigger-110 red'></i> <span class='hidden'>Export to PDF</span>",

"className": "btn btn-white btn-primary btn-bold"

},

{

"extend": "print",

"text": "<i class='fa fa-print bigger-110 grey'></i> <span class='hidden'>Print</span>",

"className": "btn btn-white btn-primary btn-bold",

autoPrint: false,

message: 'This print was produced using the Print button for DataTables'

}

]

});

myTable.buttons().container().appendTo($('.tableTools-container'));

//style the message box

var defaultCopyAction = myTable.button(1).action();

myTable.button(1).action(function (e, dt, button, config) {

defaultCopyAction(e, dt, button, config);

$('.dt-button-info').addClass('gritter-item-wrapper gritter-info gritter-center white');

});

var defaultColvisAction = myTable.button(0).action();

myTable.button(0).action(function (e, dt, button, config) {

defaultColvisAction(e, dt, button, config);

if ($('.dt-button-collection > .dropdown-menu').length == 0) {

$('.dt-button-collection')

.wrapInner('<ul class="dropdown-menu dropdown-light dropdown-caret dropdown-caret" />')

.find('a').attr('href', '#').wrap("<li />")

}

$('.dt-button-collection').appendTo('.tableTools-container .dt-buttons')

});

////

setTimeout(function () {

$($('.tableTools-container')).find('a.dt-button').each(function () {

var div = $(this).find(' > div').first();

if (div.length == 1) div.tooltip({container: 'body', title: div.parent().text()});

else $(this).tooltip({container: 'body', title: $(this).text()});

});

}, 500);

myTable.on('select', function (e, dt, type, index) {

if (type === 'row') {

$(myTable.row(index).node()).find('input:checkbox').prop('checked', true);

}

});

myTable.on('deselect', function (e, dt, type, index) {

if (type === 'row') {

$(myTable.row(index).node()).find('input:checkbox').prop('checked', false);

}

});

/////////////////////////////////

//table checkboxes

$('th input[type=checkbox], td input[type=checkbox]').prop('checked', false);

//select/deselect all rows according to table header checkbox

$('#dynamic-table > thead > tr > th input[type=checkbox], #dynamic-table_wrapper input[type=checkbox]').eq(0).on('click', function () {

var th_checked = this.checked;//checkbox inside "TH" table header

$('#dynamic-table').find('tbody > tr').each(function () {

var row = this;

if (th_checked) myTable.row(row).select();

else myTable.row(row).deselect();

});

});

//select/deselect a row when the checkbox is checked/unchecked

$('#dynamic-table').on('click', 'td input[type=checkbox]', function () {

var row = $(this).closest('tr').get(0);

if (this.checked) myTable.row(row).deselect();

else myTable.row(row).select();

});

$(document).on('click', '#dynamic-table .dropdown-toggle', function (e) {

e.stopImmediatePropagation();

e.stopPropagation();

e.preventDefault();

});

//And for the first simple table, which doesn't have TableTools or dataTables

//select/deselect all rows according to table header checkbox

var active_class = 'active';

$('#simple-table > thead > tr > th input[type=checkbox]').eq(0).on('click', function () {

var th_checked = this.checked;//checkbox inside "TH" table header

$(this).closest('table').find('tbody > tr').each(function () {

var row = this;

if (th_checked) $(row).addClass(active_class).find('input[type=checkbox]').eq(0).prop('checked', true);

else $(row).removeClass(active_class).find('input[type=checkbox]').eq(0).prop('checked', false);

});

});

//select/deselect a row when the checkbox is checked/unchecked

$('#simple-table').on('click', 'td input[type=checkbox]', function () {

var $row = $(this).closest('tr');

if ($row.is('.detail-row ')) return;

if (this.checked) $row.addClass(active_class);

else $row.removeClass(active_class);

});

/********************************/

//add tooltip for small view action buttons in dropdown menu

$('[data-rel="tooltip"]').tooltip({placement: tooltip_placement});

//tooltip placement on right or left

function tooltip_placement(context, source) {

var $source = $(source);

var $parent = $source.closest('table')

var off1 = $parent.offset();

var w1 = $parent.width();

var off2 = $source.offset();

//var w2 = $source.width();

if (parseInt(off2.left) < parseInt(off1.left) + parseInt(w1 / 2)) return 'right';

return 'left';

}

/***************/

$('.show-details-btn').on('click', function (e) {

e.preventDefault();

$(this).closest('tr').next().toggleClass('open');

$(this).find(ace.vars['.icon']).toggleClass('fa-angle-double-down').toggleClass('fa-angle-double-up');

});

/***************/

/**

//add horizontal scrollbars to a simple table

$('#simple-table').css({'width':'2000px', 'max-width': 'none'}).wrap('<div style="width: 1000px;" />').parent().ace_scroll(

{

horizontal: true,

styleClass: 'scroll-top scroll-dark scroll-visible',//show the scrollbars on top(default is bottom)

size: 2000,

mouseWheelLock: true

}

).css('padding-top', '12px');

*/

}

</script>

{% endblock %}

|